Frissítés dátuma:

Ön is szembesült már azzal a problémával, hogy weboldala a nehezen megszerzett pozícióit egyik pillanatról a másikra elveszítette?

Az utóbbi időben futottunk bele mi is több olyan esetbe, amikor hasonló dolog történt az ügyfeleink néhány weboldalával. A találati listán az látszódott, hogy az oldalak váratlanul 30-40 pozíciót is hátrébb sorolódtak egy-egy kulcsszóra. Mindamellett az is érdekesség volt, hogy a megszokott kulcsszó url párosítás is felborult és egy teljesen másik aloldal url-jét jelenítette meg a kulcsszóhoz a Google. Természetesen ezen problémák hátterében számos ok meghúzódhat, mi most az általunk felderített esetekről számolunk be. Tehát mi okozhatta a fenti problémákat?

Az első amikor a Google megpróbálja elérni a webhelyet, de nem tud kommunikálni a DNS-szerverrel. Itt vagy a DNS-szerver nem érhető el, vagy magával a domainre irányuló DNS-útválasztással van gond. A probléma orvosolható, ha a DNS-szolgáltató felé jelezzük a gondunkat. Gyakran elég csak megkérni őket, hogy ne tiltsák le a Googlebotot.

A másik és ez a gyakoribb ok, hogy a kiszolgáló szerver tűzfala akadályozza a Googlebot munkáját, így az nem tudja feltérképezni a weboldalunkat. (Ezért fordulhat elő, hogy a Google a nem elérhető oldalt kihagyja és helyére választ egy másik – még nem vizsgált – számára még releváns oldalt az adott kulcsszóhoz.) A problémát kiválthatja egy helytelenül konfigurált tűzfal (pl. egyszerűen kitiltják a robotokat ami akár egy frissítés következménye is lehet), vagy a DoS védelem (Denial-of-Service túlterheléses támadások elleni védelem). Mindkettő megakadályozza, hogy a robot bejárja az oldalt. Tudjuk jól, hogy a jó tárhely szolgáltatás fontos része a védelmi rendszer. Éppen ezért gyakran állítják be a rendszergazdák, hogy a szokatlanul gyakori szerverkéréseket tiltsák. Ennek eshet áldozatául a Googlebot is, hiszen sokszor több kérést küld mint egy átlagos emberi felhasználó ami aktiválhatja a védelmi mechanizmust. A problémát a tárhely szolgáltató felé kell jelezni, amit gyorsan orvosolni is szoktak.

Hol tudunk utána nézni, hogy tényleg ez utóbbi problémával van dolgunk?

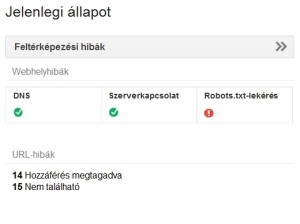

Ha van webmester eszközünk, akkor ott az irányítópultnál látható, hogy a robots.txt-t nem érte el a Google.

A problémáról több információ látható a Feltérképezés / Feltérképezési hibák aloldalon. Itt grafikonon látható, hogy mióta nem érhető el a fájl. Minél hosszabb ez az idő, annál nagyobb károkat szenved el a weboldalunk a pozíciók terén.

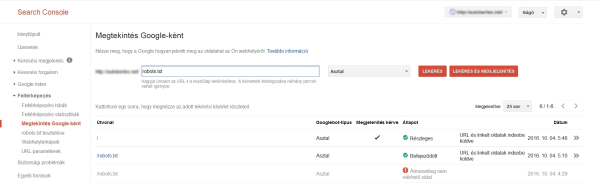

A Feltérképezés / Megtekintés Google-ként menüpontban is látható a probléma, ha mi magunk kezdeményezzük a robots.txt lekérését.

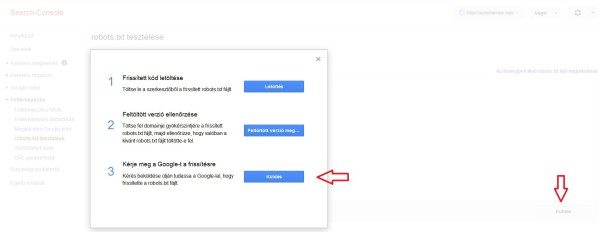

Ha a szolgáltatótól azt az információt kapjuk, hogy javították a problémát, akkor itt ellenőrizhetjük ismételten a fájlunkat. Ha mindent rendben találunk, akkor még érdemes újra beküldeni az index-be minden oldalt a biztonság kedvéért. Ezt a robots.txt fájl esetében is célszerű megtenni. Ehhez menjünk a Feltérképezés / robots.txt tesztelésemenüpontra.

Ha 4-5 nap elteltével sem látunk javulást és nem sikerült visszanyernünk a pozícióinkat, akkor sajnos gyanakodhatunk, hogy valami más is áll még a weboldal romlásának hátterében.

Olvasson többet a keresőoptimalizálásról!